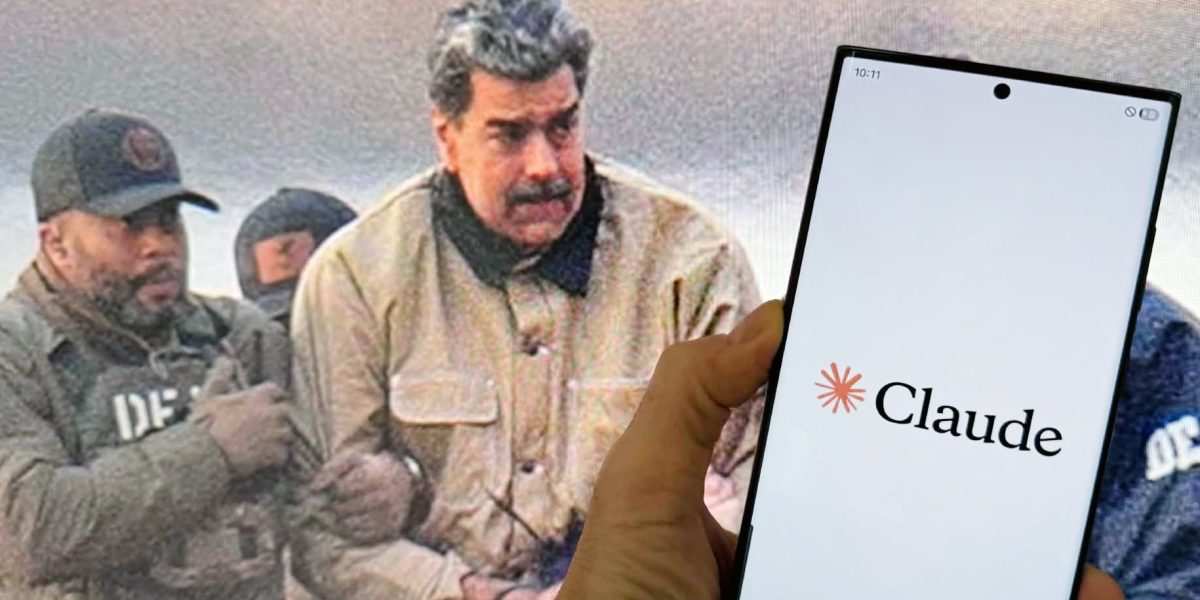

Armata SUA a utilizat o tehnologie de inteligență artificială avansată în timpul operațiunii din Venezuela, care a dus la capturarea lui Nicolás Maduro, conform unui raport recent. Această dezvăluire ridică serioase întrebări despre limitele și utilizarea AI-ului în misiuni sensibile, inclusiv în acțiuni cu potențiale implicații geopolitice și legale. În spatele acestei povești stă modelul Claude, dezvoltat de compania de AI Anthropic, și modul în care tehnologia a fost integrată în infrastructura militară americană, în contextul unui interes tot mai mare pentru utilizarea inteligenței artificiale în domeniul securității naționale.

### Utilizarea clandestină a AI-ului Claude în misiuni militare

Potrivit informațiilor preluate de Reuters dintr-un articol al Wall Street Journal, armata SUA ar fi trecut peste limitele tradiționale pentru a folosi modelul Claude în timpul operațiunii din Venezuela. Informațiile indică faptul că această utilizare nu s-ar fi făcut direct, ci prin intermediul unei platforme de analiză de date și tehnologii de infrastructură, dezvoltată de Palantir, companie cunoscută pentru colaborarea strânsă cu Pentagonul și alte agenții federale. Astfel, Claude a fost integrat în sistemele de analiză existente, utilizând ceea ce specialiștii numesc o „ușă laterală”, pentru a fi aplicat în condiții unde tehnologia comercială obișnuită nu avea acces.

Deși afirmațiile din raport nu au fost încă verificate independent, ele accentuează un trend alarmant: tehnologiile de inteligență artificială pot fi adoptate și în zone și operațiuni considerate clasificate, fără a fi neapărat controlate de normele și reglementările tradiționale pentru domeniul militar. Această posibilitate atrage, inevitabil, atenția asupra riscurilor și a dezinformării legate de utilizarea AI-ului în operațiuni de forță, mai ales atunci când aceste tehnologii pot ajunge în mâinile celor care nu le controlează integral.

### Presiuni asupra marilor companii de AI pentru acces în rețelele clasificate

Un alt aspect controversat al acestei povești îl reprezintă și eforturile oficiale ale Pentagonului de a accelera accesul la modele de inteligență artificială pentru rețelele și sistemele sale speciale. Reuters semnalează că autoritățile americane exercită presiuni asupra celor mai mari producători de AI, precum OpenAI și Anthropic, să-și adapteze tehnologiile pentru mediile clasificate. În esență, se urmărește reducerea restricțiilor și facilitarea utilizării rapide a acestor modele în situații critice, unde timpul poate face diferența între succes și eșec.

De ce această prioritate? În lumea modernă, AI-ul devine un instrument indispensabil pentru analiza rapidă a datelor, anticiparea amenințărilor și coordonarea în teren. Pentru armata americană, accesul aproape instant la cele mai eficiente modele de AI – chiar și în medii extrem de sensibile – poate reprezenta o diferență strategică majoră. Însă această direcție ridică și probleme etice, legale și de control, întrucât tehnologia, dacă nu este gestionată responsabil, poate fi exploatată în moduri nescontate, sau chiar periculoase.

### Un paradox și întrebări despre limitele utilizării AI în scopuri militare

Cel mai delicat aspect al acestei povești rămâne însă posibilitatea ca modelul Claude, în ciuda politicilor stricte ale companiei Anthropic, să fi fost utilizat pentru acțiuni de forță. Politicile internaționale și cele interne ale companiei interzic explicit utilizarea AI pentru violență, arme sau supraveghere inadecvată. Însă, dacă raportul care sugerează implicarea în transportarea lui Maduro pentru a răspunde acuzațiilor de trafic de droguri se dovedește adevărat, se naște o întrebare clară: unde se termină analiza și unde începe implicarea practică în acțiuni violente sau ilegale?

Capturarea liderului venezuelan, dacă a fost facilitată de AI, ar constitui un precedent periculos, demonstrând că tehnologia poate fi folosită în moduri neprevăzute sau necontrolate. În plus, această poveste creează presiuni majore asupra companiilor dezvoltatoare de AI, dar și asupra decidenților politici, pentru a stabili reguli clare privind utilizarea tehnologiilor de ultimă generație în domeniul securității naționale.

Pe măsură ce aceste dezvăluiri ies la lumină, ramura AI aplicată securității devine tot mai complicată. Deși interesul pentru dezvoltarea rapidă și avansată a modelelor precum Claude este evident, riscurile asociate utilizării lor în contexte militare, mai ales în cazul unor operațiuni clasificate și scutite de control public, devin tot mai evidente. Iar viitorul acestei tehnologii depinde în mare măsură de hotărârile și reglementările pe care le vor impune liderii mondiali, pentru a preveni ca inovațiile din domeniul AI să nu devină, în cele din urmă, arme de necontrolat.