AMD stabilește o nouă țintă în domeniul inteligenței artificiale: yottaflops. Anunțul făcut recent, în contextul CES 2026, nu este doar o promisiune tehnologică, ci o orientare clară către scalarea AI la niveluri fără precedent. Într-un domeniu în continuă transformare, această mișcare indică faptul că industria nu mai vede AI doar ca o funcție adăugată, ci ca o infrastructură fundamentală pentru viitorul tehnologic.

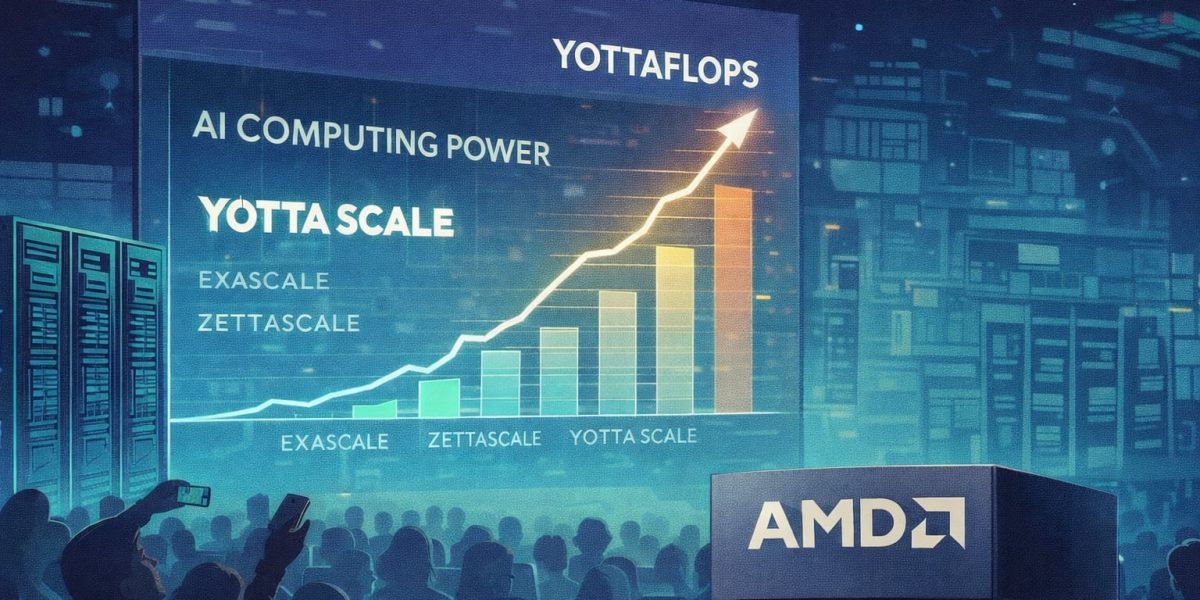

De la exascale la yottaflops: o revoluție în ritmurile de calcul

Pentru a înțelege amploarea ultimelor anunțuri, trebuie să ne uităm la scara progresului. În 2022, un supercomputer exascale, Frontier, a intrat în TOP500, punând bazele pe performanța de un exaflop, sau 10^18 operații pe secundă. De atunci, drumul a fost unul clar: creșteri accelerate, de la zettaflops (10^21 operații) la yottaflops — miliarde de ori mai mare, de 10^24 operații pe secundă. “Diferența nu este incrementală, ci de ordinul ‘altă lume'”, explică specialiștii, iar această diferență de scară sugerează o schimbare fundamentală, nu doar o evoluție a hardware-ului.

Ce înseamnă această scalare? În esență, nu mai compari clusterele de supercalculatoare, ci ecosisteme întregi de infrastructuri distribuite. La această scară, sistemele se vor baza pe colaborarea unui număr imens de centre de date, rețele de calcul distribuite și tehnologii de edge computing, pentru a asigura performanța necesară pentru AI de ultimă generație.

Schimbarea de paradigmă: de la antrenare la inferență continuă

În ultimii ani, focusul în AI fusese aproape exclusiv pe antrenarea modelelor. Cercetătorii au urmat cursa pentru modele tot mai mari, cu seturi de date tot mai vaste, încercând astfel să creeze inteligențe din ce în ce mai sofisticate. Însă, acum, accentul se mută către inferență și execuție continuă. În lumea reală, AI trebuie să fie disponibilă 24/7, să interacționeze cu miliarde de utilizatori, să proceseze fluxuri ininterupt de date și să funcționeze în multiple domenii, de la text și voce, la imagini, video și senzori din medii fizice.

Această schimbare are implicații majore asupra economiei calculului. Un model poate fi antrenat o singură dată, dar inferența devine un proces perpetuu. Astfel, nu mai contează doar dimensiunea modelului, ci frecvența cu care este folosit și complexitatea sarcinilor pe care le gestionează. În practică, procesarea a trilioane de tokenuri zilnic nu mai reprezintă un obiectiv individual, ci o parte integrantă din ecosistemul AI modern.

Distribuția la scară largă și provocările sistemice

Un alt aspect esențial al scalării AI la nivelul yottascale este distribuția. Chiar dacă s-ar putea construi clustere uriașe pentru antrenare și inferență, realitatea operatională a sistemelor AI necesită o distribuție eficientă, cu latență minimă și costuri controlabile. În acest context, centrul nu mai este un singur supercomputer, ci o rețea globală de centre de date interconectate, edge computing și dispozitive locale.

Aici intervine importanța unui sistem integrat, capabil să orchestreze hardware-ul și software-ul pentru a funcționa sinergic. AMD, de exemplu, promovează conceptul „Helios”, o infrastructură deschisă ce urmărește densitatea de calcul, eficiența energetică și integrarea completă între componente. Potrivit specialiștilor, următorul pas nu constă doar în fabricarea unor cipuri rapide, ci în crearea unui ecosistem sustenabil, capabil să suporte performanțe extreme fără a fi blocat de consumul de energie sau de complexitatea infrastructurii.

Perspectiva pe termen lung indică o consolidare a conceptului de AI distribuit, în care scalarea va fi mai mult despre gestionarea fluxurilor și resurselor, decât despre puterea brută a unui singur chip sau server. În timp ce tehnologia evoluează, va fi crucial să urmărim nu doar reducerea costurilor, ci și modul în care aceste tehnologii devin accesibile și integrate în viața cotidiană, deschizând drumul pentru adevărata revoluție a inteligenței artificiale.